As big techs prometem que a inteligência artificial (IA) vai ultrapassar a capacidade humana nos próximos anos, mas pesquisas recentes sugerem que essa visão pode estar baseada em premissas equivocadas. Para especialistas, os modelos atuais reproduzem linguagem em escala, porém isso não significa que máquinas estejam se aproximando da forma como pensamos ou raciocinamos.

O argumento central é que linguagem e inteligência não são a mesma coisa. Embora humanos usem linguagem para comunicar ideias, ela não necessariamente origina ou define nossa capacidade de pensar. Esse contraste está no centro de uma discussão que coloca em dúvida previsões otimistas feitas por executivos como Mark Zuckerberg, Sam Altman e Dario Amodei.

CEOs de big techs apostam que AGI está próxima

Nos últimos anos, líderes do setor passaram a afirmar que a inteligência artificial geral (AGI, na sigla em inglês) está no horizonte. Mark Zuckerberg diz que “desenvolver superinteligência está à vista”. Dario Amodei acredita que sistemas mais inteligentes do que ganhadores do Nobel podem surgir já em 2026. Sam Altman, da OpenAI, afirma estar confiante de que já existe clareza sobre como construir AGI.

Segundo o discurso dessas empresas, basta ampliar o volume de dados e recursos computacionais para alcançar uma forma de inteligência maior que a humana. A aposta é que, com o avanço de chips e data centers, sistemas como ChatGPT, Gemini, Claude e outras ferramentas poderão reproduzir todas as capacidades cognitivas humanas.

O limite dos modelos de linguagem

Entretanto, os cientistas argumentam que essa lógica parte de um erro conceitual. Modelos de linguagem são, essencialmente, mecanismos de previsão de texto, treinados em grandes volumes de palavras e correlações estatísticas. Eles funcionam a partir de relações matemáticas, não do raciocínio que construímos biologicamente.

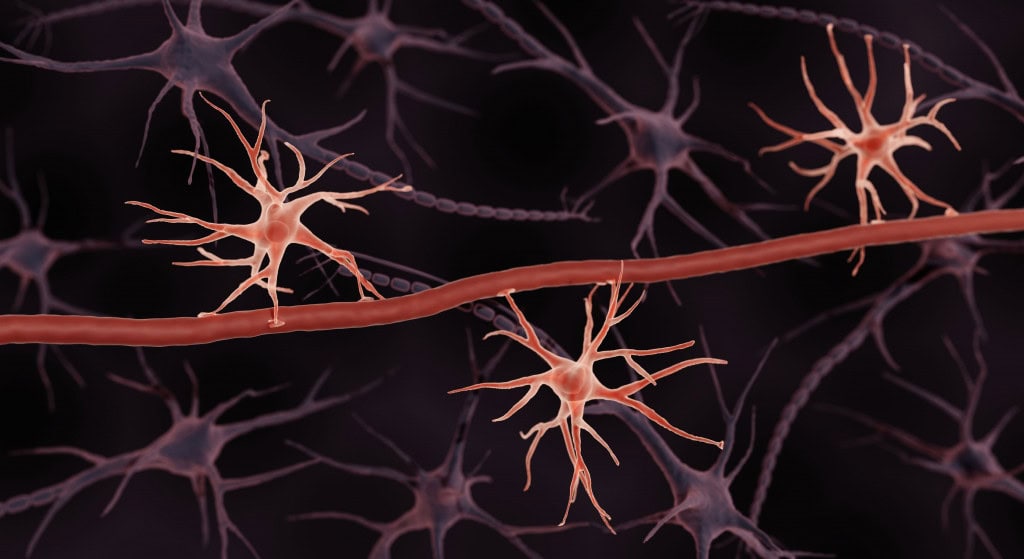

O problema é que, segundo décadas de pesquisa em neurociência, o pensamento humano é maior do que linguagem. Estudos com ressonância magnética mostram que diferentes áreas do cérebro atuam quando raciocinamos, resolvemos problemas ou tentamos entender outras pessoas — regiões distintas das que usamos para falar ou compreender frases.

Pesquisas reforçam a separação entre pensamento e fala

Um artigo publicado ano passado na revista Nature por Evelina Fedorenko, Steven T. Piantadosi e Edward A.F. Gibson resume esse entendimento. Os autores defendem que a linguagem é principalmente uma ferramenta de comunicação, não a fonte do pensamento. Eles destacam que pessoas com danos cerebrais severos podem perder a capacidade de falar sem perder a habilidade de raciocinar, interpretar situações, resolver problemas ou fazer deduções lógicas.

Crianças pequenas também demonstram isso: antes de falar, exploram o mundo, aprendem por tentativa e erro e desenvolvem compreensão sobre causa e efeito. Segundo os cientistas, a cognição melhora com a linguagem, mas não depende dela para existir.

Críticas ao foco exclusivo em LLMs

Mesmo dentro da indústria, cresce a percepção de que ampliar apenas modelos de linguagem não leva à inteligência geral. Há desenvolvedores defendendo modelos que entendam o mundo além do texto, com memória persistente e capacidade de planejar ações complexas.

Pesquisadores e executivos como Yoshua Bengio, Eric Schmidt e Gary Marcus propõem uma definição de AGI baseada em múltiplas capacidades, como memória, raciocínio, planejamento e interpretação visual, e não apenas domínio de leitura e escrita. A ideia é que inteligência seja composta por diversos componentes, não por uma única habilidade ampliada.

Leia mais:

O que é o Modo Investigar do ChatGPT? Entenda o recurso da inteligência artificial

5 doenças que a inteligência artificial já auxilia no diagnóstico

O que é superinteligência artificial? Veja como ela pode mudar o futuro da humanidade

Mesmo com mais habilidades, desafios permanecem

Ainda assim, essa abordagem não resolve todas as questões. Mesmo que uma IA consiga desempenhar todas as tarefas humanas com alta competência, isso não significa que será capaz de criar novas formas de conhecimento. Para filósofos como Thomas Kuhn e Richard Rorty, grandes avanços surgem quando alguém se torna insatisfeito com os modelos atuais e propõe novas interpretações da realidade.

Um sistema treinado apenas a partir de dados existentes pode reproduzir padrões, mas não necessariamente terá motivo para ultrapassá-los. O resultado pode ser uma tecnologia eficiente para reorganizar, combinar e aplicar informações, sem romper paradigmas ou expandir a compreensão humana de forma original.

Assim, o trabalho dos cientistas sugere que os modelos atuais são máquinas de linguagem, não de pensamento. Eles dependem dos dados fornecidos e ficam limitados ao vocabulário existente. Já pessoas conseguem ir além, desenvolver novas ideias e transformar a forma como entendemos o mundo.

O post Cientistas afirmam que IA baseada em texto não reflete inteligência real apareceu primeiro em Olhar Digital.